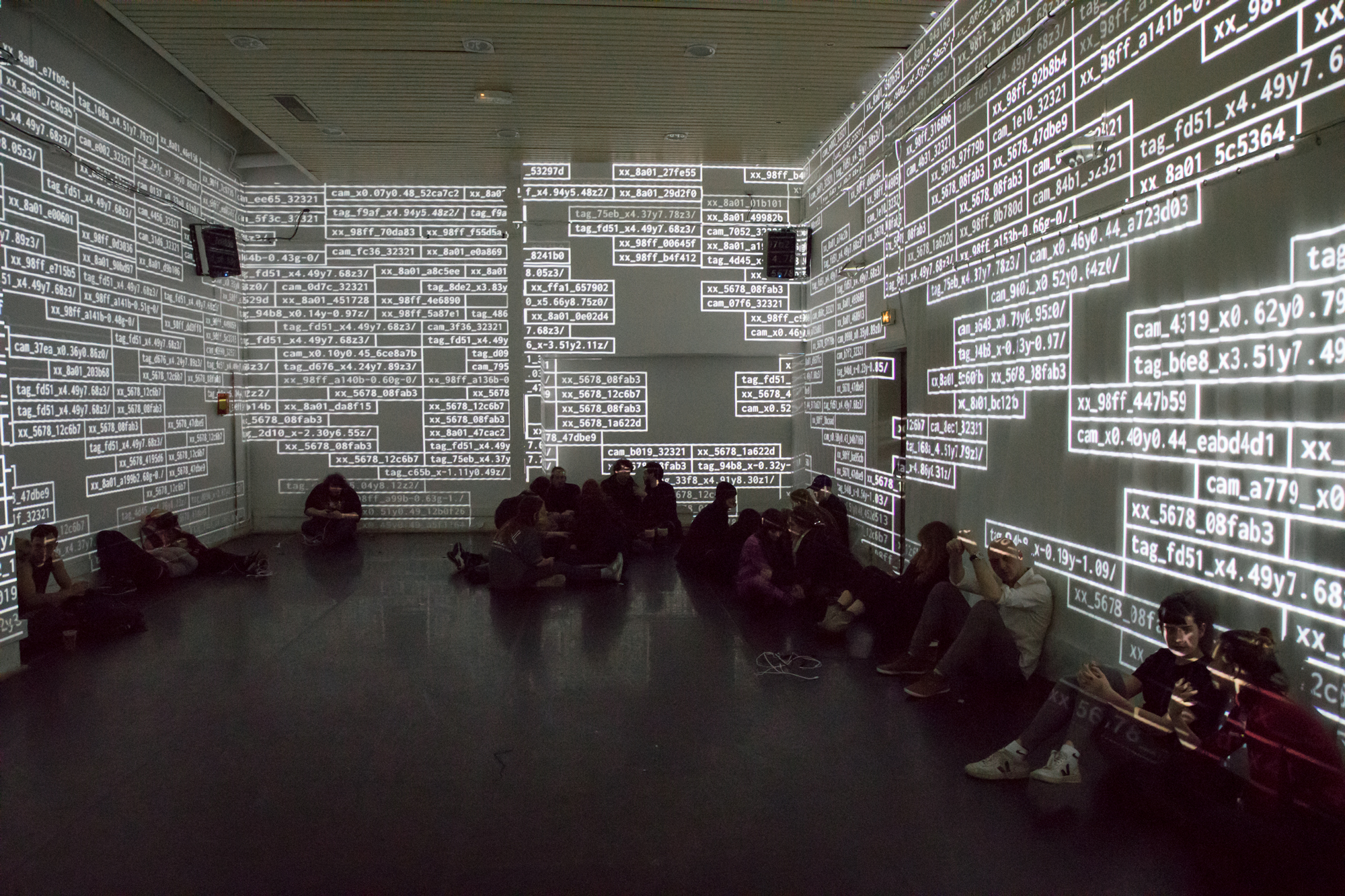

Datarase

Installations artistiques en circuit fermé et circuits courts écologiques, comment et pourquoi court-circuiter les dispositifs numériques ?

Samuel Bianchini

Réalisation informatique et design sonore | Ianis Lallemand

Dispositif de projection vidéo | idscènes

Projet développé dans le cadre du groupe de recherche Reflective Interaction d'Ensadlab (EnsAD - Université Paris Sciences et Lettres) © EnsAD - 2018

Vidéo | Alice Brygo et Thomas Vauthier

« 108 Mégapixels ! Oubliez les anciens capteurs 12 mégapixels ». C’est l’annonce actuelle d’un grand constructeur de Smartphone. Rappelons ce que cela signifie : que chacune des photographies prises avec un tel appareil est composée de plus de 108 millions de pixels (pour une résolution de 12032 par 9204 pixels) soit autant de petits carrés colorés définis chacun (en simplifiant) par un ensemble d’informations de placement et de colorimétrie. Couplé à un système de prise de vue qui produit plusieurs images à chaque déclenchement en l’anticipant et le poursuivant pour augmenter les chances de faire « la » bonne image, cela démultiplie encore la masse d’informations. La plupart des usagers n’hésiteront pas, d’ailleurs, à faire beaucoup d’images pour être plus sûrs de leurs faits. Sur ces mêmes appareils grand public, la vidéo n’est pas en reste avec une résolution désormais de 8k, soit 3840 x 2160 pixels pour chacune des images qui pourront ainsi être affichées sans difficulté sur des écrans cinématographiques à raison de 25 images par seconde, produisant ainsi d’importants flux numériques pour transporter toutes nos images, de quelque nature que ce soit.

La captation de nos activités et, au-delà, de nos vies, semble ainsi bien assurée : nul besoin de trop se concentrer pour faire des images de qualité, les développements technologiques – reposant essentiellement sur un accroissement quantitatif – nous promettent de compenser nos défaillances. Et même si la plupart de ces nombreuses images ne seront jamais exposées à nos regards ou à ceux de nos descendants, nous pouvons nous rassurer : elles seront mises en mémoire, nous garantissant ainsi une forme de postérité et de lutte fondamentale contre la mort. Pour être certain de leur pérennité, il faut les sauvegarder, les dupliquer sur un second support au moins et les délocaliser, car un lieu unique de stockage présente un risque. La sauvegarde est le gage de cette postérité et sa garantie la plus « naturelle » et la plus simple serait le « cloud », cette informatique « dans les nuages » dont le terme et le marketing associé renforcent l’idée de technologies dématérialisées.

Nous savons toutefois qu’il n’en est rien : délocalisées on ne sait où, toutes ces données sont transmises par réseaux à des machines qui les stockent et les copient. Ces données peuvent également faire l’objet d’analyses automatiques essentiellement basées sur des programmes relevant du domaine du « Machine learning ». Ces programmes se régalent d’autant plus qu’ils disposent de nombreuses données, de « big data ». En effet, l’approche fondamentale de cette composante majeure de la dénommée « intelligence artificielle » repose sur une approche inductive, « bottom-up », c’est-à-dire la construction de règles et / ou de modèles à partir de l’analyse de nombreux cas, et cela suivant un régime dynamique et itératif possiblement sans fin. L’analyse massive, délocalisée et automatique de ces données pose alors de nombreux problèmes éthiques. L’encadrement juridique – à la façon de la RGPD européenne (Règlement général sur la protection des données) et des garde-fous de la Cnil (Commission nationale de l’informatique et des libertés) – tente de contraindre ces développements. Mais ces derniers reposent sur des dynamiques techno-sociales et des arguments économiques favorables au profiling, en particulier lorsque ces données sont délocalisées.

Si le domaine de l’image est l’un des plus producteurs et consommateurs de données, c’est qu’il repose sur un principe matriciel démultiplicateur. Ce dernier se trouve désormais de plus en plus impliqué dans de nombreuses structures de calcul, à commencer par celle du Machine learning et de ses « réseaux de neurones ». En effet, plutôt que d’adopter des structures impliquant des processus consécutifs, il s’avère nécessaire d’opter pour des modalités de traitement massivement parallèles s’appuyant, elles aussi, sur des structures matricielles qui font alors appel au GPU (Graphic Processing Unit) dont la construction matérielle repose sur de très grandes quantités de petits processeurs montés en parallèle. C’est ainsi que ces structures et ce type de matériel venant du domaine de l’image, et plus spécifiquement du jeu vidéo, sont de plus en plus déployés sur les supercalculateurs nécessitant des ressources énergétiques très conséquentes.

Produire, enregistrer, transférer, traiter : bien loin d’être dématérialisé, tout cela à un coût physique et énergétique de plus en plus important. Ce problème est aujourd’hui sur la place publique1. La croissance numérique facteur de croissance économique est devenue l’un des problèmes écologiques préoccupants. Désormais, il faut penser aussi la décroissance numérique alors que ces outils apparaissent en même temps comme des soutiens indispensables à l’organisation de nos sociétés, ainsi que l’a révélé davantage encore la crise sanitaire de la Covid-19.

Le « cloud computing » et ses nombreux services sont sans doute les plus révélateurs et les plus problématiques de ces développements technologiques. Il s’agit autant de recevoir et d’héberger des données que d’offrir des accès à de nombreux autres services, en commençant à nouveau par les images, comme avec la VOD, extrêmement consommatrice de bande passante. Car, au-delà du stockage, c’est bien la transmission qui pose problème. Et c’est aussi celle-ci qui est particulièrement sollicitée dès lors qu’il s’agit de communiquer en permanence avec des médias délocalisés et des outils, eux aussi, à distance. Le cloud computing signe bien ce que Jérémy Rifkin avait parfaitement anticipé avec son ouvrage L’âge de l’accès2 : plutôt que de les distribuer, les éditeurs de logiciels tendent désormais à proposer l’accès à distance et en continu à leurs outils centralisés sur des serveurs. Loin d’être une avancée, cette tendance consacre toujours plus le modèle « client-serveur » afin de nous convertir en « terminaux », à la façon de notre bon vieux minitel. Un modèle centralisateur qui permet de contrôler les usages et de toujours plus capter et raffiner les données provenant de ces mêmes usages et de leurs usagers. Outre les problématiques éthiques dues à cette dépendance permanente, ce contrôle continu qu’avait bien anticipé Gilles Deleuze3 a aussi un coût, énergétique et donc écologique. Inhérents au traitement et développement actuel des infrastructures et services numériques, les problèmes écologique et éthique sont désormais associés.

Que peuvent les artistes ? Que peuvent-ils alors qu’ils participent pleinement de l’usage de ces technologies ? Celles-ci constituent en effet des moyens de représentation difficilement contournables et l’exigence esthétique convoque souvent les dernières avancées techniques. Cependant, puisqu’il s’agit d’un domaine sur lequel ils peuvent avoir prise, sont-ils tenus d’être des « usagers » ? Ne peuvent-ils pas contribuer à une autre orientation de ces dispositifs ?

Ce champ et les questions qu’il suscite sont complexes : elles sont au croisement de nombreuses disciplines et, à vrai dire, elles résistent même à se poser en terme disciplinaire tant ce sont des questions de société dont les tenants et aboutissants sont aussi sociaux, politiques, techniques, économiques qu’environnementaux.

En tant qu’artiste et chercheur, j’ai été conduit, avec une équipe pluridisciplinaire, à me confronter à ces questions et à tenter d’y apporter des réponses, des réponses évidemment partielles, mais possiblement maladroites, mais qui participent de la construction de ce champ de réflexion et d’une nécessaire résistance en actes.

En tant qu’artiste et chercheur, j’ai été confronté, avec une équipe pluridisciplinaire, à ces questions auxquelles nous avons tenté d’apporter des réponses, des réponses évidemment partielles mais qui participent de la construction de ce champ de réflexion et d’une nécessaire résistance en actes.

Novembre 2009, l’Espace Pasolini de Valenciennes, lieu d’expérimentation pour le spectacle vivant, est transformé en dance floor pour l’ouverture du festival franco-belge Next : nous créons Discontrol Party4.

Espace Pier Paolo Pasolini - Théâtre international de Valenciennes, France, 20 novembre 2009, ouverture du Festival NeXt

Programmation musicale : Sylvie Astié (Doki Doki)

Avec : Pan Sonic ; Sexy Sushi ; Pigeon Funk ; Computer Truck ; Hassan K ; Sascii

Dispositif vidéo (collaboration artistique et ingénierie) : Keyvane Alinaghi | Développement informatique visuel : Oussama Mubarak | Traitement des données et conseil technique : Sylvie Tissot | Assistant : Antoine Villeret

Avec le partenariat du CiTu et de l’iMAL, Center for Digital Cultures and Technology, Bruxelles, Belgique

Discontrol Party est un dispositif qui fait se rencontrer deux mondes : celui des technologies de surveillance les plus évoluées et celui de la fête. Piste de danse, salle de concert et de spectacle sont aménagées pour être aussi bien sous les feux des projecteurs que d’un puissant dispositif de contrôle informatisé (vision par ordinateur, RFID-UWB, caméra infrarouge, face detection, identification, IoT, traçabilité, géolocalisation indoor, interaction via smartphones, BLE, etc.). Les salles de spectacle qui accueillent ce dispositif deviennent, le temps d’une nuit, un night-club aménagé en salle de contrôle : loin des effets de lumières ou autre vijaying, le public, tout en faisant la fête, est confronté aux multiples visualisations du système informatique qui l’observe et tente de l’analyser.

Tel un jeu à l’adresse d’un groupe ou un « Beta Testing » à grande échelle, le défi est ici annoncé : comment, par l’activité festive, déjouer le système, l’entraîner dans la confusion, et, pourquoi pas, le faire buguer ? Car, ici, le public est invité à une fête dont le « monitoring » du dispositif sur lequel il agit lui est donné à voir : les cartographies et listings de ses déplacements et comportements, leurs tentatives d’interprétation, les images des caméras de surveillance transformées pour et par l’analyse automatique, la représentation des activités du système informatique, les visualisations sur lesquelles il est possible d’agir via smartphones…

Surveillance et fête, si ces mondes paraissent en tous points opposés, ils reposent pourtant tous deux sur des activités de groupe, et même de foule. Mais le premier - le plus souvent à destination d’espaces publics – mise d’abord sur des mouvements de foule organisés : flux de personnes, file ou salle d’attente, quai d’embarquement, etc. Les mouvements rapides, désordonnés et même parfois fusionnels de la fête sont peu compatibles avec le repérage, le suivi et la recherche d’individualisation des dispositifs de surveillance et de contrôle de plus en plus automatisés : reconnaissance de formes, d’individus, de comportements, traçabilité… En provoquant leur confrontation et le possible débordement d’un monde par l’autre, ce dispositif prospectif pourrait bien renouer avec quelques traits primitifs d’un de nos plus vieux rituels : la fête.

Repris en 2011 pour deux soirées à la Gaîté lyrique, à Paris5, le dispositif évolue en intégrant de nouvelles technologies de tracking portées directement par le public, mais c’est bien, à nouveau, la dimension éthique qui est mise en jeu. En effet, on l’aura compris, le cœur du projet est à cet endroit, en résonance étroite avec le fameux texte de Gilles Deleuze, Post-scriptum sur les sociétés de contrôle6.

La Gaîté Lyrique, Paris, 24 et 25 juin 2011

Programmation musicale : Sylvie Astié (Dokidoki)

Projet développé dans le cadre du groupe de recherche Reflective Interaction d'EnsadLab, laboratoire de l’École nationale supérieure des Arts Décoratifs (EnsAD - Université PSL), et à l’Université de Valenciennes et du Hainaut-Cambrésis, avec le soutien de l’Agence nationale de la recherche (ANR) ainsi que de la Maison européenne des sciences de l’homme et de la société (MESHS) de Lille, France, dans le cadre du projet de recherche PRATICABLES. Dispositifs artistiques : les mises en oeuvre du spectateur. Avec le soutien du pôle de compétitivité Cap Digital et de la Région Île-de-France dans le cadre du programme Futur en Seine 2011 en partenariat avec la Gaîté Lyrique. Avec le partenariat de Philips.

Programme musical : Schlachthofbronx ; Ceephax acid crew ; Absolute Body Control ; Errorsmith ; DJ Krikor ; Captain Ahab ; Covox ; Bass Jog (DJ Elephant Power + FX.Randomiz) ; Nero’s Day at Disneyland ; DJ Krikor

Régie technologique : Antoine Villeret | Réalisation informatique de l’environnement visuel (KetchupAddict) : Oussama Mubarak avec la collaboration de Tomek Jarolim et une contribution de Marie-Julie Bourgeois | Captation embarquée RFID-UWB : Xavier Boissarie et Jonathan Tanant (Orbe) avec la technologie et le partenariat de la société Ubisense | Dispositif vidéo (collaboration artistique et ingénierie) : Antoine Villeret et Keyvane Alinaghi | Conseil technique : Cyrille Henry

Design des accessoires RFID : Claire Bonardot, Ornella Coffi, Cécile Gay, Jennifer Hugot, Pauline Jamilloux, Laure Pétré, Valentine Rosi, Chloé Severyns, Alice Topart, étudiantes en Design textile et matière et Design vêtement à l’EnsAD en 2011

En 2018, l’expérience se poursuit avec une troisième version de Discontrol Party7, cette fois dans le cadre de « Nous ne sommes pas le nombre que nous croyons être » à la Cité internationale des arts et du festival de danse « Faits d’hiver » de micadanses. Nous tentons alors de répondre à cette question inévitable : que faisons-nous de toutes les données ainsi produites par l’activité du public, une fois mises en œuvre, transformées en représentations ? Le dispositif proposé a, naturellement, d’abord soulevé cette question sous l’angle éthique. Mais la crise écologique s’imposant à tous les champs, elle nous a rattrapés. Comment conjuguer la question écologique avec celle de l’usage de ces données produites et traitées en temps réel, ici et maintenant ? C’est donc bien à cette double problématique éthico-écologique que nous devons désormais faire face, en pratique.

Programmation musicale : Sylvie Astié (Dokidoki)

Avec les lives et DJ sets de Rebeka Warrior, Candie Hank, Retrigger, Front de Cadeaux, Mr Marcaille, WR2OLD, Sinead O' Connick Jr.

micadanses, Paris, nuit du 2 au 3 février 2018

Discontrol Party #3 a été créé dans le cadre de : “Nous ne sommes pas le nombre que nous croyons être”, un événement de la Fondation Daniel et Nina Carasso en partenariat avec La Chaire arts et sciences de l'École Polytechnique, de l'École nationale supérieure des Arts Décoratifs - PSL et de la Fondation Daniel et Nina Carasso, et du festival de danse “Faits d'hiver” de micadanses. Commissariat de l'événement “Nous ne sommes pas le nombre que nous croyons être” : Mélanie Bouteloup, directrice de Bétonsalon - Centre d'art et de recherche et de La Villa Vassilieff.

Projet développé dans le cadre du groupe de recherche Reflective Interaction d'EnsadLab, laboratoire dirigé par Emmanuel Mahé, École nationale supérieure des Arts Décoratifs, PSL Research University, Paris.

Direction technologique : Colin Bouvry, Dominique Cunin, Jonathan Tanant | Captation vidéo : Colin Bouvry | Développement informatique (applications pour smartphones, data visualisations, video mapping) : Dominique Cunin, Jérémy De Barros, Léon Denise, Florent Dubois, Ianis Lallemand, Oussama Mubarak, Jonathan Tanant | Ingénierie réseau : Benoît Hérard | Dispositif de projection vidéo et régie son et lumière : idscènes | Assistanat de production : Gwenaëlle Lallemand

Avec la participation des artistes et designers : Sylvie Astié, David Bihanic, Antoine Chapon, Dominique Cunin, Jérémy De Barros, Alexandre Dechosal, Léon Denise, Lucile Haute, Ianis Lallemand, Oussama Mubarak et le collectif Transcyberien.

Design des accessoires RFID : Claire Bonardot, Ornella Coffi, Cécile Gay, Jennifer Hugot, Pauline Jamilloux, Laure Pétré, Valentine Rosi, Chloé Severyns, Alice Topart, étudiantes en Design textile et matière et Design vêtement à l'EnsAD en 2011.

Les recherches et développements pour ce dispositif sont menés en lien avec le développement de Mobilizing.js, environnement de programmation pour les écrans mobiles, élaboré par EnsadLab, à destination des artistes et des designers : www.mobilizing-js.net

Un projet réalisé avec le soutien de la Chaire arts et sciences de l'École Polytechnique, de l'École nationale supérieure des Arts Décoratifs - PSL et de la Fondation Daniel et Nina Carasso.

Remerciements : Christophe Aubry (idscènes), Mélanie Bouteloup (Bétonsalon – Center for Art and Research and Villa Vassilieff), Pascal Delabouglise (micadanses), Jérôme Gensollen (EnsAD), Olivier Jean (idscènes), Christophe Martin (micadanses), Boris Molinié (micadanses), Estelle Mury, Yoan Romano, Élodie Tincq et l'équipe de Sonic Protest

Une réponse radicale s’est imposée : nous allons détruire ces données, en local, juste après leur usage événementiel. En effet, on l’a vu, si le traitement de données a bel et bien un coût énergétique, leur transport, leur enregistrement et donc leur stockage – nécessairement démultiplié – concentrent les problématiques éthiques tout en ayant un impact environnemental considérable. Garantir qu’il ne restera rien de ces captations, pas de traces de contrôle après l’activité, après la fête, permettait une première réponse à ce double problème. Et, plutôt que d’occulter ce processus d’effacement, pourquoi ne pas le mettre en œuvre, lui aussi ? Cela permettait de rendre compte de la réponse que nous pouvions apporter à cette question, en « garantissant » visuellement ce processus. Réciproquement, cette mise en œuvre nous incitait à considérer de façon beaucoup plus générale cette problématique éthico-écologique.

C’est ainsi qu’a été créée une installation parallèle à Discontrol Party, interfacée avec son dispositif de traitement de données : Datarase, initialement intitulée Data Crematorium. Datarase8 est une installation qui met en œuvre et valorise la destruction de données numériques au plus proche de leurs lieux et temps de production. Les murs d’une grande salle sombre sont recouverts de briques, des briques projetées, chacune d’elles représentant un lot d’informations regroupées sous un même identifiant. Chaque brique affiche ainsi son « ID » qui correspond à un acteur dans Discontrol Party (spectateur, caméra, tag, smartphone, etc.) et donc à un ensemble de données relatif à la captation d’une séquence d’activité de cet acteur. Apparaissant par le haut, ces briques ainsi indexées descendent pour s’entasser jusqu’à former des lignes qui disparaissent alors, à la façon d’un jeu de casse-briques. Ainsi représentée, cette disparition n’en est pas moins réelle : elle signe l’effacement concret de ces données. Déployée en marge d’événements producteurs de données, à l’instar de Discontrol Party, Datarase se présente comme une sorte de lounge à l’abri de toute captation, immergeant son public dans un environnement graphique et sonore afin de lui donner à contempler et à penser la nécessité d’une décroissance numérique qui passe par l’acceptation et même le plaisir de l’effacement.

Réalisation informatique et design sonore : Ianis Lallemand

Dispositif de projection vidéo : idscènes

Ce projet est développé dans le cadre du groupe de recherche ReflectiveInteraction d'Ensadlab, laboratoire de l'École nationale supérieure des Arts Décoratifs (EnsAD - Université Paris Sciences et Lettres) avec le soutien de la Chaire arts et sciences de l'École polytechnique, de l'EnsAD-PSL et de la Fondation Daniel et Nina Carasso.

Photo (en haut) : © Alexis Komenda | Photo (en bas) : © Samuel Bianchini

Cette esthétique de la destruction, du processus de destruction, n’est pas sans nous rappeler la démarche artistique de Gustav Metzger9 ou même l’œuvre majeure de Jean Tinguely – la machine suicidaire que constituait Hommage à New York (1960) –, nous appelant à apprécier l’art quand il se produit, en tant qu’événement, plutôt que comme objet sur lequel capitaliser.

Mais il nous faut peut-être revenir sur une référence encore plus spécifique : la manière dont pouvait être agencée une œuvre aussi marquante que Present Continuous Past(s) de Dan Graham. Cette installation vidéo de 1974 confronte le spectateur à sa propre image avec un délai de 8 secondes. À cette époque, il suffisait de disposer de deux appareils vidéo : un enregistreur et un lecteur. Chacun assure sa fonction, mais ils agissent côte à côte, sur la même bande. Le lecteur donne à voir l’image 8 secondes plus tard en étant placé à la juste distance du premier. Le dispositif est monté en boucle, effaçant inlassablement l’image pour permettre son réenregistrement momentané. L’installation offre les conditions d’une performance, celle du public10. C’est bien cette dimension événementielle qui sera l’apanage des installations vidéo en circuit fermé réalisées par quelques artistes majeurs dans les années 1970 comme Peter Campus, Bruce Nauman, Bill Viola, et, bien entendu, Dan Graham. Ces œuvres sont ainsi dénommées « en circuit fermé » parce qu’elles exploitent une technique élémentaire de la vidéo alors naissante : à la différence du cinéma, il était possible de filmer sans enregistrer. C’est ainsi que ces artistes vont déployer leurs installations devenues des « dispositifs »11, une fois celles-ci appareillées, le plus souvent avec des caméras de surveillance. Les publics se voient alors confrontés à différents régimes d’apparition de leur propre image par une diffusion en direct.

Discontrol Party s’inscrit dans cette filiation tout en renouvelant le genre par des captations ne générant pas à proprement parler des images, mais plutôt des données puis des « visualisations », traces de suivis individualisés. Nous sommes bien passés du régime synoptique de la surveillance à celui du contrôle, comme le décrit si finement et si tôt Gilles Deleuze12. Nos sociétés de contrôle reposent sur la discrimination, la division, pour que chacun.e, chaque « dividuel », fasse l’objet d’un tel « tracking ». Mais le corps social résiste dès qu’il ne se prête pas au jeu de cette distinction fondamentale, au fonctionnement de ces dispositifs de contrôle et qu’il adopte collectivement, au contraire, le régime de la fusion et de la confusion festive. Le circuit fermé vaut pour Discontrol Party : si le traitement de données passe par un enregistrement, rien n’oblige à conserver celui-ci ou, sinon, à conserver l’ensemble de ces données. C’est ce type de stratégie qui est actuellement déployé sur des dispositifs qui imposent le filtrage et la destruction à la source, tant ils génèrent de données. Ainsi, le Grand collisionneur de hadrons (LHC) du Cern, plus grand accélérateur de particules du monde, produit-il en fonctionnement environ 1000 téraoctets par seconde… Un tri le plus tôt possible est indispensable : c’est ce à quoi sont dédiées des cartes électroniques appelées « Trigger » qui ne conserveront en moyenne qu’une information sur 40.000. Sur les supercalculateurs, le machine learning est aussi sollicité pour raffiner les données et donc en détruire une partie, la machine se prenant alors elle-même comme objet : une machine en prise avec elle-même, qui se dépense pour moins dépenser. Si ces processus sont mis en œuvre dans des dispositifs actuels des plus experts, c’est pourtant de telles logiques qu’il s’agirait d’intégrer dans nos usages au quotidien, à rebours de l’obstination à vouloir tout sauvegarder et transférer. Et c’est donc bien à la source, en local, qu’il est indispensable d’opérer, sans cela c’est en grande partie peine perdue. Il faut court-circuiter nos dispositifs numériques, nos pulsions productrices, sauvegardistes et connexionnistes… Comment, pour pouvoir continuer à profiter des atouts du numérique, repenser, ici aussi, la relocalisation, jusqu’à l’échelle individuelle, et adopter une forme de circuit court en réponse au problème éthico-écologique soulevé par la façon dont on traite, transmet, sauvegarde et donne accès aux données, à nos données ? À l’instar de bien d’autres domaines, l’option globalisante du tout connecté n’est pas tenable : il faut pouvoir choisir nos liens. Et si le recyclage ne peut répondre au productivisme, pour les datas c’est de toute façon un non-sens : les sauvegarder ne fait que dépenser. Réduire la production et trier pour détruire à la source appelle une attitude responsable, pratique et critique de chaque instant. Si les artistes peuvent produire des conditions d’expériences esthétiques et réflexives dans ce champ, c’est en abordant ce médium avec un souci de réflexivité. Ce dernier pourrait s’inscrire dans la droite ligne d’un héritage moderniste prônant l’autoréflexivité, mais, cette fois – loin d’une tautologie du médium interrogeant le médium – en prenant en compte ces enjeux sociétaux et environnementaux. S’inscrivant dans un art des dispositifs, un art résolument opératoire, ces pratiques appellent à poser les conditions d’un médium à l’épreuve de lui-même. Comment, désormais, mettre en œuvre des dispositifs qui opèrent en lutte avec eux-mêmes, qui adoptent un registre agonistique où les opérations, loin d’être lisses, s’effectuent sur le mode d’une résistance productive ? Déléguer ainsi aux œuvres des formes de responsabilité et même de résistance en actes doit permettre d’en partager l’expérience avec des publics qui sont aussi des usagers. À la manière dont l’écosophie de Félix Guattari articule différentes pratiques écologiques13, ce partage d’expérience appelle aussi à considérer cette double question éthique et écologique comme un seul et même problème, consubstantiel à la pratique de nos données et aux données de nos pratiques.